Une Intelligence Artificielle peut-elle être éthique ?

Avant toute chose, qu’est ce que l’éthique ? Qu’est ce que l’éthique dans le domaine de la santé ? En quoi une IA peut elle, ou ne pas être, éthique ? Quels seraient les critères ? Qu’est ce que l’IA Act européen et le GT3 de la DNS ?

Ces notions seront certainement en partie abordées lors du prochain « café éthique » au SIB le 29 juin.

Aussi, pour profiter pleinement des interventions, nous vous proposons un retour sur des notions « de bon sens », mais qui seront la base de la régulation et du développement des applications à base d’IA dans le monde de la santé. Aussi est il important de bien les définir.

L’éthique, c’est quoi ?

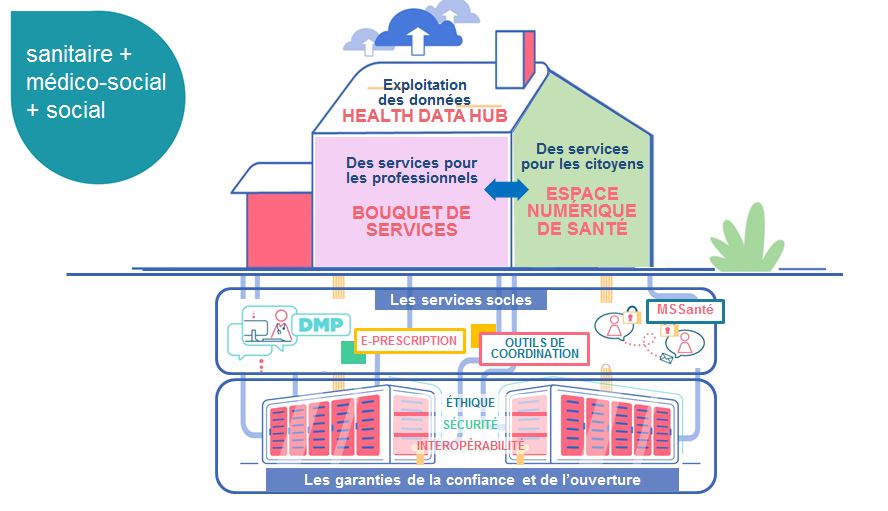

Au même titre que la sécurité, l’éthique est une des briques de la « maison » de « ma santé 2022 ». Garantie de confiance dans le système, l’éthique facilite le développement auprès des citoyens.

Alors comment la définir ? Les définitions européennes, nationales, ou médicales de l’éthique se ressemblent, et tournent autour de 5 (parfois bien plus) axes que voici, avec à quelques exemples :

- La bienveillance : dans le domaine de la santé, la bienveillance implique d’utiliser l’IA pour promouvoir le bien-être des patients et pour leur offrir des soins de qualité.

- L’autonomie : La technologie embarquant de l’IA en santé doit garantir l’autonomie décisionnelle de l’utilisateur. Pour ce faire, la solution d’IA doit donner à cet utilisateur la capacité de comprendre sa décision.

- La non malfaisance : elle consiste à ne pas nuire. Elle rejoint le premier principe de prudence médicale « Primum non nocere« .

- L’équité : comme par exemple permettre une accessibilité renforcée de ces solutions performantes, mais aussi d’éviter les biais injustes grâce à une conception universelle

- Développement durable : Permettre un développement soutenable de ces solutions (avec une balance d’un bilan carbone acceptable), mais également établir une gouvernance des données (quid de la souveraineté nationale, ou au moins européenne sur les données ?)

Quelles régulations ?

Européennes

La commissions européenne travaille actuellement sur un AI Act : https://artificialintelligenceact.eu/ qui inclue des lignes directrices éthiques (https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai)

Vous en trouverez une excellente description sur Wikipedia : mais en résumé, l’objectif est de :

- Garantir la sécurité des systèmes d’IA introduits sur le marché européen et respecter les droits fondamentaux des citoyens et les valeurs de l’UE

- Garantir la sécurité juridique pour stimuler les investissements et l’innovation dans l’IA

- Renforcer la gouvernance et appliquer efficacement les lois existantes sur les droits fondamentaux et les exigences de sécurité pour les systèmes d’IA

- Promouvoir le développement d’un marché unique pour les applications d’IA légales, sûres et dignes de confiance et limiter la fragmentation du marché.

En parallèle de ces discussions, la commission met à disposition un site interne pour les éditeurs, afin de les accompagner dans le respects de ces règles : Altai

Nationales :

Le « GT3 » de la cellule éthique du numérique a publié ses recommandations de bonnes pratiques pour intégrer l’éthique dès le développement des solutions d’Intelligence Artificielle en Santé : mise en œuvre de « l’éthique by design » .

https://esante.gouv.fr/sites/default/files/media_entity/documents/ethic_by_design_guide_vf.pdf

Conclusion

L’interdiction de ChatGPT en Italie, ou à ses employés pour Samsung (pour des raisons de protection de données) … A l’aube d’une explosion de l’IA dans le monde médical comme ailleurs, des craintes, mais surtout une régulation émerge. Et à l’instar du RGPD, la règlementation européenne, l’IA Act pourrait avoir des répercussions extraterritoriales.

Des questions passionnantes, que le SIB évoquera par sa participation au café Ethique du 29 juin !